Cherry Studio:开源AI客户端,通过第三方客户端的方式来使用DeepSeek。来解决DeepSeek官方经常出现的“服务器繁忙”的问题。 但是还是存在两个问题需要解决:

客户端只能在Mac、Windows、Linux上用,手机使用不方便 还不支持联网搜索功能。

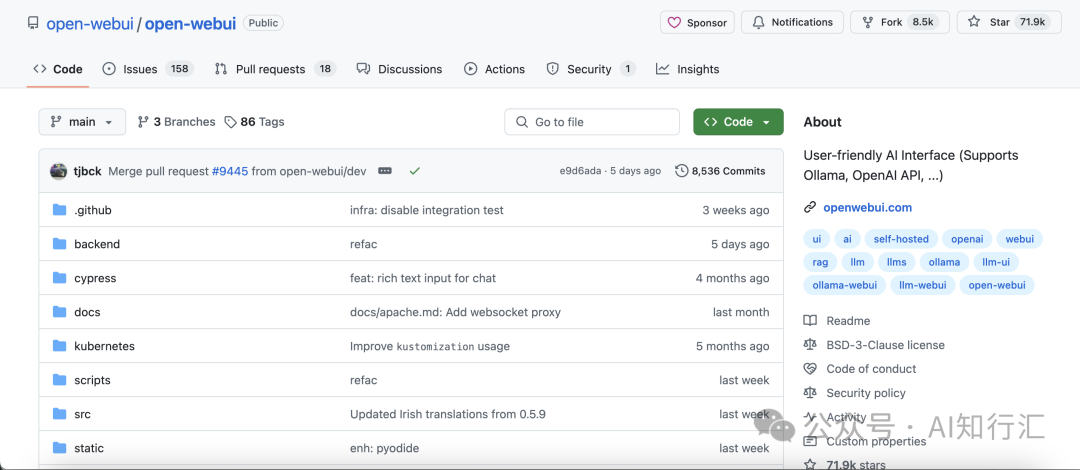

在Ollama本地模型部署社区工具中Open WebUI是一个开源浏览器前端界面项目,支持联网搜索。我们可以通过它来使用DeepSeek的的联网功能。

Open WebUI 是什么?

Open WebUI 是一个开源的、可扩展、功能丰富且用户友好的本地托管 AI 平台,设计用于完全离线运行。它支持各种 LLM 运行,如 Ollama 和 OpenAI 兼容的 API,并内置了用于 RAG 的推理引擎,使其成为一个强大的 AI 部署解决方案。

主要功能有:

本地部署设置 OpenAI API 集成兼容 全面的 Markdown 和 LaTeX 支持 直接轻松创建 Ollama 模型 本地和远程 RAG 集成 使用 RAG 进行网络搜索 Web 浏览功能 图像生成集成 ......

部署Open WebUI

Open WebUI支持跨平台的部署,如本地电脑、Linux服务器等。我们这里用阿里云服务器部署的方式。

环境准备: 阿里云服务器(Ubuntu)

安装有3种方式:

直接python+虚拟环境安装 用conda安装 用docker安装

本文使用直接python+虚拟环境安装

安装Open WebUI

创建虚拟环境,并激活

python3 -m venv venv

source venv/bin/activate

安装 Open WebUI

pip install open-webui

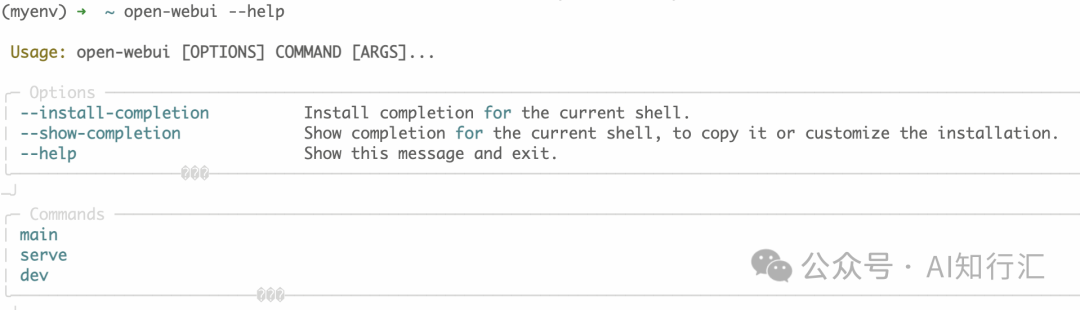

输入open-webui --help测试一下

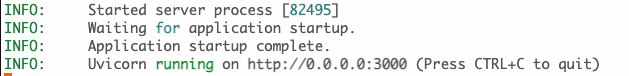

启动服务器,(可以指定服务端口,这里以3000为例)

open-webui serve --port 3000

启动需要一段时间,在看到如下信息表示服务启动完成。

阿里云控制台,确认放开端口访问

访问Open WebUI,配置硅基流动,使用DeepSeek R1

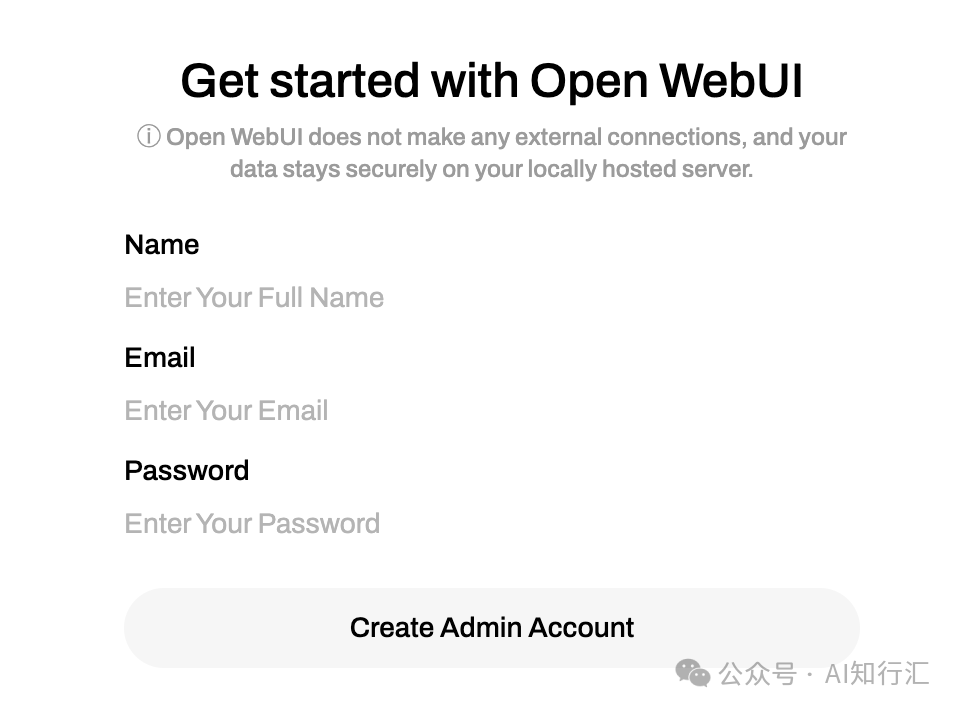

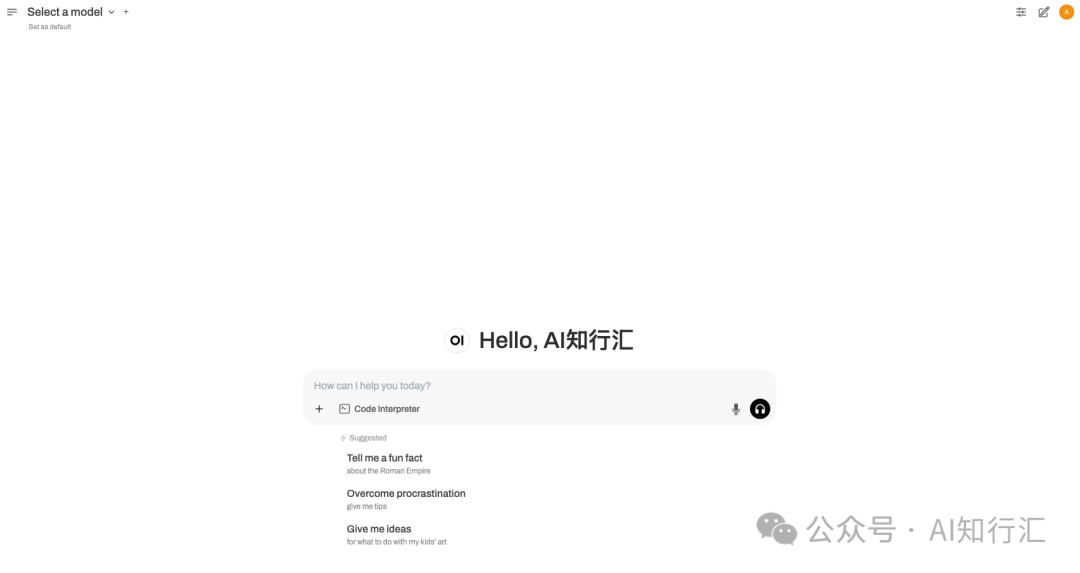

1、登录Open WebUI

访问http://服务器公网IP:3000,开始使用Open WebUI,首次使用需要创建管理员账号 创建账号,进入系统

创建账号,进入系统

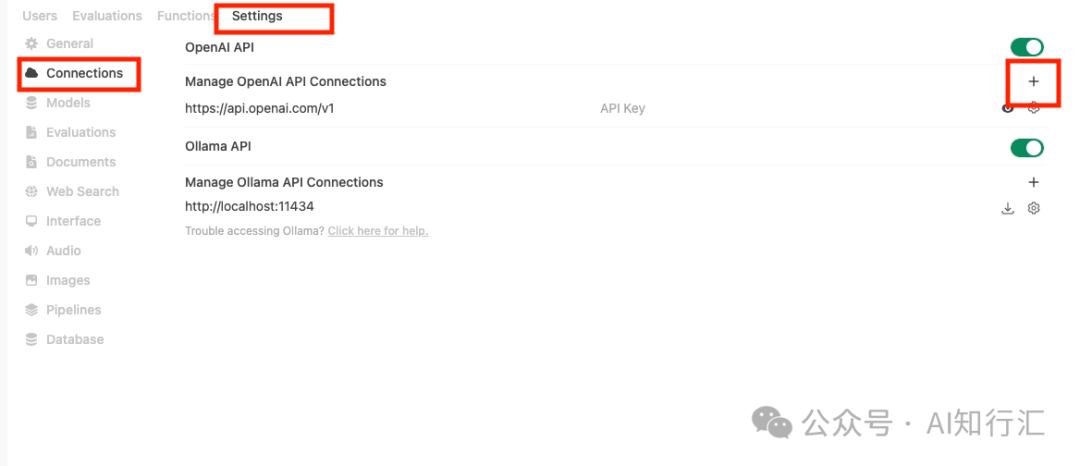

2、配置硅基流动API连接

在设置-》管理面板-》连接

配置添加硅基流动的API和DeepSeek的模型

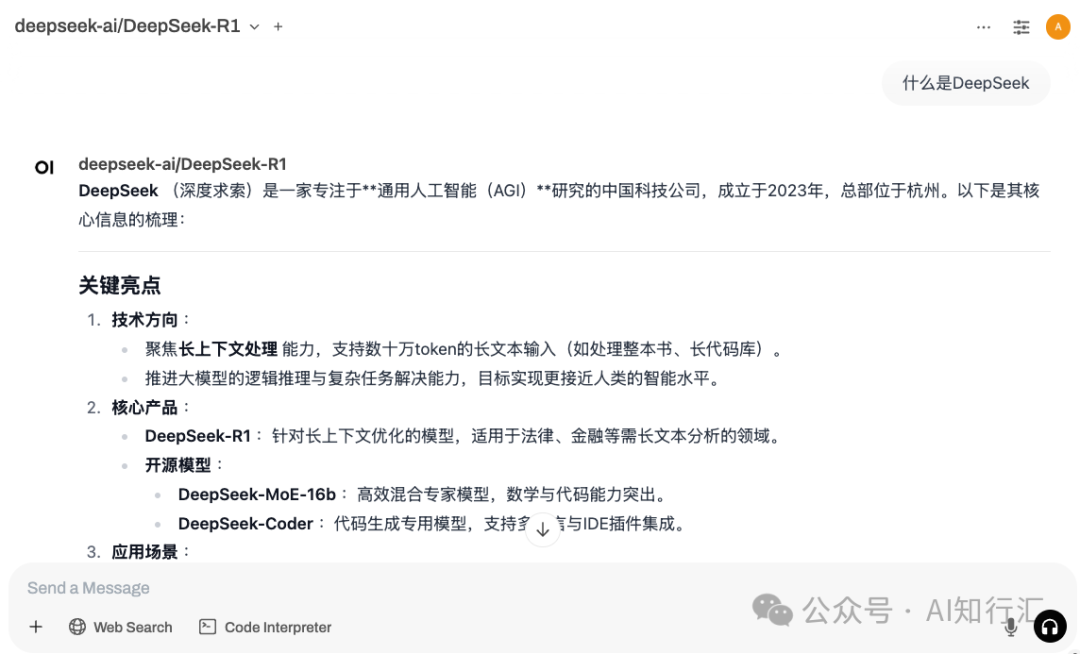

3、选择DeepSeek-R1模型使用

联网搜索

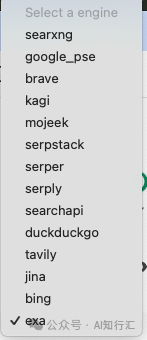

在管理面板中设置选择联网搜索的引擎,如:duckduckgo, brave等。

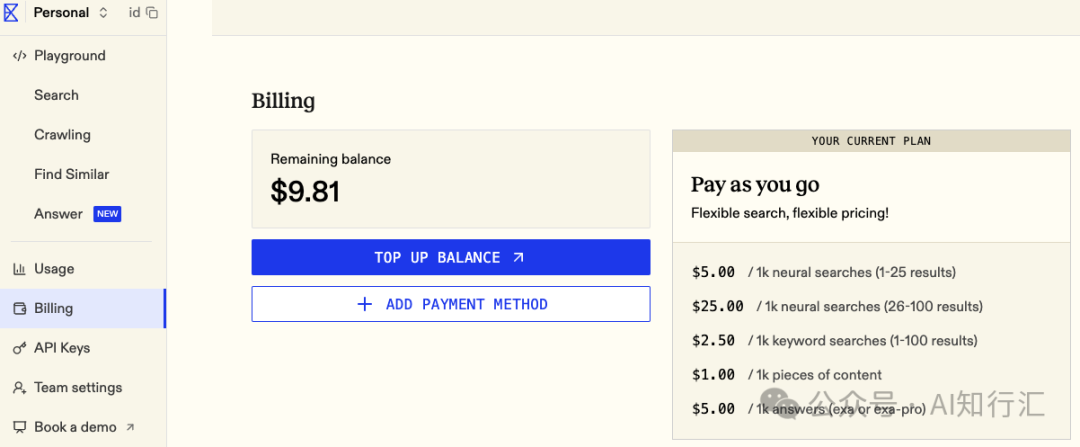

推荐使用duckduckgo 唯一的缺点是需要访问国外网络。 Brave 需要注册token 才能方便的使用。 exa.ai是专为AI打造的搜索引擎,目前对注册用户赠送10美元的试用。 这里选择exa.ai作为测试联网搜索。

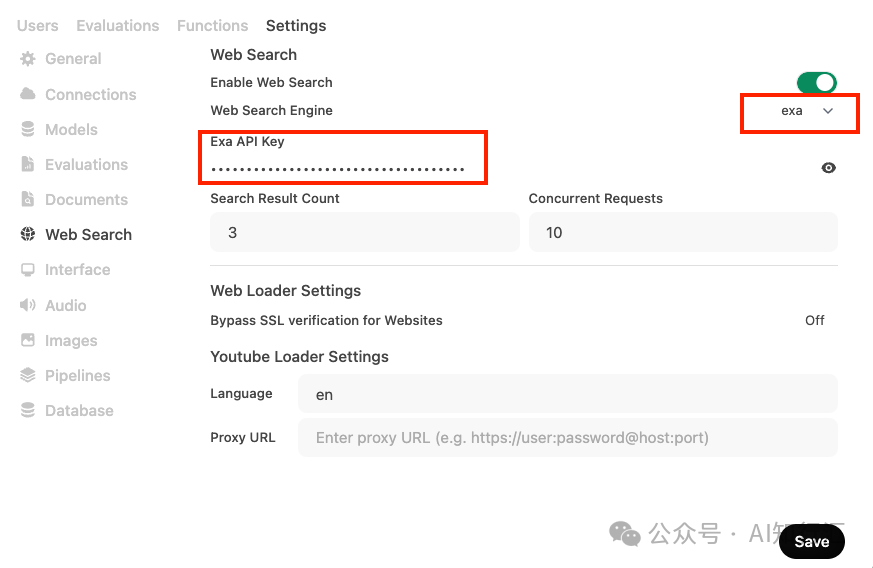

Open WebUI中配置exa 的API Key

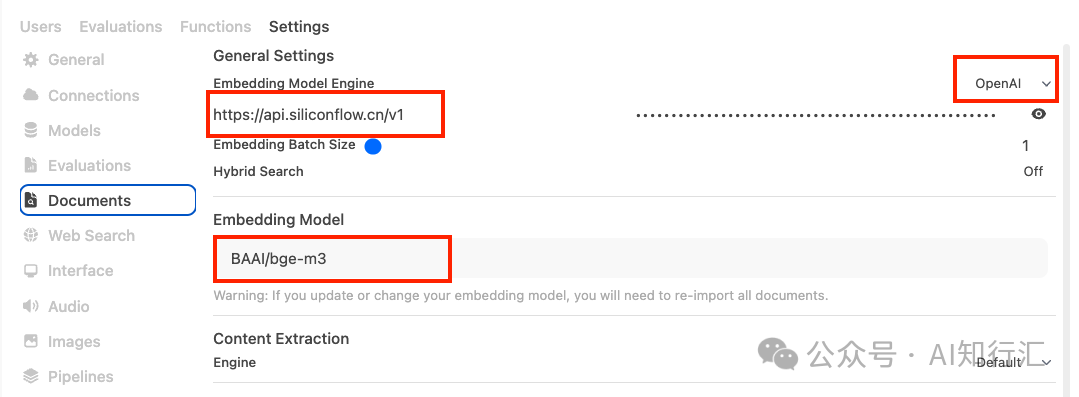

联网搜索需要使用到嵌入模型。默认的embeding模型配置在支持中文方面存在encode问题。硅基流动上也提供嵌入模型。

Open WebUI中修改文档的嵌入模型配置

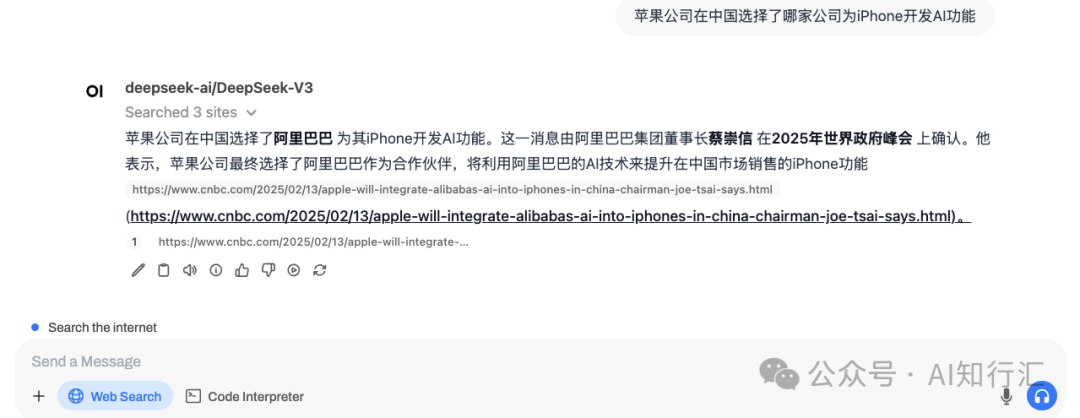

测试一下联网搜索功能

成功!可以看到已经能够支持联网搜索来回答我们的问题了。

总结

Open WebUI提供了一个基于浏览器的开源前端界面,用户可以方便本地部署,与大模型进行交互,实现问答、文本生成等功能。支持了联网搜索,DeepSeek 能够通过联网搜索来获得最新的互联网信息。

特点如下:

开源免费 基于浏览器的访问,电脑、手机上都可以访问。 支持本地部署,数据隐私有保障。 除了支持Ollama这种本地部署模型外也支持通过API方式使用大模型 功能强大,包括用户管理、对话管理、预设提示词、格式解析等等 内置RAG推理引擎,联网搜索其实就是RAG的一个应用。

还有些不方便的地方:

还不支持显示DeepSeek-R1的思考过程 因为机器配置和网络原因,联网搜索能够使用,但并不是特别顺畅。

参考资料:

https://openwebui.com/ https://github.com/open-webui/open-webui https://docs.openwebui.com/features/ https://cloud.siliconflow.cn/models?types=embedding https://exa.ai/

推荐本站淘宝优惠价购买喜欢的宝贝:

本文链接:https://sg.hqyman.cn/post/9152.html 非本站原创文章欢迎转载,原创文章需保留本站地址!

微信支付宝扫一扫,打赏作者吧~

微信支付宝扫一扫,打赏作者吧~