0x01 前言 对数据敏感的企业想要部署自己的大模型该(如:DeepSeek R1)该选用什么方式呢? Ollama还是vllm呢? 我先说结论:Ollama适用于开发测试,vLLM适用于生产环境部署下面我会进行详细的选型对比,让你有一个更清晰的认知。0x02 选型对比 Ollama与vLLM都是针对大语言模型(LLM)部署和推理的开源框架,但它们在设计目标、技术特点和适用场景上有显著的差异。下面通过多个维度给出具体对比说明1. 核心定位与部署方式Ollama :

文章简介:将本地开发的 Node.js 项目部署到线上服务器是开发者常见的工作流程之一。在这篇文章中,我将详细介绍如何将本地的 Node.js 服务通过宝塔面板(BT 面板)上线。宝塔面板是一个强大的服务器管理工具,具有简洁的 UI 和丰富的功能,适合用来管理服务器、部署应用程序和维护网站。正文:宝塔面板(BT)提供了方便的 Web 界面,简化了服务器管理和网站运维的流程。将本地 Node.js 服务部署到宝塔服务器,经过以下几个步骤即可轻松实现。第一步:准备你的本地 Node.js 服务在将服

随着人工智能(AI)技术的蓬勃发展,催生了各种专门的硬件设计,以优化 AI 和神经网络的运算效率。在这些硬件加速器中,NPU(神经处理单元)和 GPU(图形处理单元)经常被拿来做对比,尤其是在加速 AI 任务方面。接下来,我们将深入探讨 GPU 和 NPU 的特点和区别,并分析它们各自的优缺点。本文内容包括NPU 简介GPU 简介NPU 和 GPU 快速对比NPU 和 GPU 的区别NPU 与 GPU:性能对比实施问题与存储需求NPU 简介NPU 神经处理单元NPU 是专门为优化 AI 和神经网

NPU(神经处理单元)是专为 AI 任务量身打造的加速器,它能够显著提升机器学习(ML)任务的处理速度,同时还可以兼顾能效。2024 年,搭载 NPU 的笔记本电脑将越来越普及。这类笔记本电脑可以轻松处理人工神经网络所需的复杂计算,并为用户带来诸多基于机器学习的先进功能。例如,Windows Studio 效果就可以利用 NPU 来实时优化视频通话中的图像和音频效果。接下来,我们将介绍如何在 Windows 11 系统中检查你的电脑是否搭载了 NPU。NPU 通常与主 CPU 集成在一起,比如

生成式 AI 正在席卷全球。从智能手机到电脑,乃至未来的各种数字设备,AI 几乎无处不在。AI 的广泛应用需要强大的算力,而传统的 CPU 和 GPU 已经越来越难以胜任。于是,NPU(神经处理单元)应运而生。现在,像三星 Galaxy S22、S23 和 S24 等旗舰智能手机已经开始搭载 NPU。不过,NPU 要在个人电脑中普及还需要一些时间。Intel 和 AMD 等芯片巨头已经开始推出集成 NPU 的处理器,如 Intel 的 Meteor Lake、Core 和 Core Ultra

LLM 大型语言模型是推动生成式 AI 聊天机器人迅猛崛起的核心技术。像 ChatGPT、Google Bard 和 Bing Chat 这样的工具都依赖于大型语言模型生成类似人类的响应来回答你的提示和问题。但是,LLM 大型语言模型到底是什么,它们又是如何工作的呢?在本文中,系统极客将为大家解密大型语言模型 。本文内容涵盖什么是 LLM 大型语言模型LLM 大型语言模型如何工作LLM 大型语言模型有哪些局限主流 LLM 大型语言模型有哪些GTPLaMDA

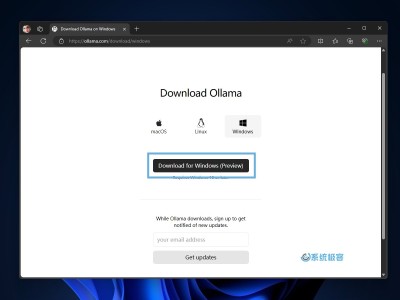

Ollama 的出现为 AI 爱好者带来了新的可能性。越来越多的工具和平台,如 OpenAI Translator、NextChat 和 LoboChat 等,都已经支持调用 Ollama 在本地运行的大语言模型 (LLM)。这不仅为 AI 新手提供了一种便捷的「入门玩法」,也为经验丰富的开发者开辟了新的探索途径。Ollama on Windows(预览版)的推出,彻底改变了在 Windows 设备上进行 AI 开发的格局。无论你是 AI 领域的探索者,还

目录 1 简介2 准备2.1 参数说明2.2 参数获取2.2.1 corpid获取2.2.2 agentid 获取2.2.3 secret获取2.3 设置企业可信IP3 推送消息3.1 关注企业微信3.2 推送代码简介企业微信开放了消息发送接口,企业可以使用这些接口让自定义应用与企业微信后台或用户间进行双向通信。接口文档:https://developer.work

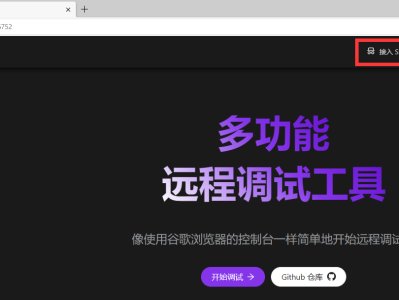

简介PageSpy 是一款用来调试远程 Web 项目的工具。它可以像使用浏览器开发者助手(F12)一样,去查看远程网页控制台、网络请求、页面内容、缓存等信息,也可以直接下发JS指令,对网页进行控制。能够帮助我们实时查看用户侧的网页状态。开源地址:https://github.com/HuolalaTech/page-spy-web使用场景任何无法在本地使用控制台调试的场景,都是 PageSpy 可以大显身手的时候!一起来看下面的例子:本地调试 H5、Webview 应用:以往有些产品提供了可以在

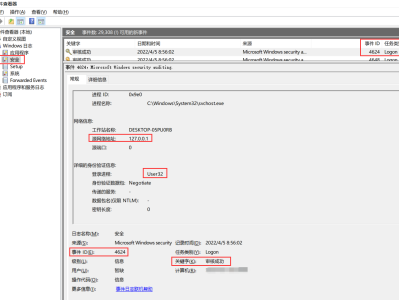

前言开启Windows服务器远程桌面服务后,为了查询用户登录的时间、IP及次数等信息,需要在事件查看器中查看,不是很方便。本篇文章主要实现了通过PHP来查询登录事件,并把登录事件中包含的关键信息通知给系统管理员。原理Windows登录成功的事件ID是:4624(登录失败为4625),事件中包含了登录账户名、登录源IP和端口等信息:可以通过powershell的Get-EventLog命令来查询事件:Get-EventLog -LogName Security -In

简介总所周知,windows的3389端口是个危险端口,开启后容易被爆破密码,但有时候为了运维方便,又不得不开启。本文给出一段使用PHP开启和关闭RDP服务的代码供参考。使用以下代码,可以在不需要RDP服务时关闭RDP,需要时再打开。开关RDP服务原理开启和关闭远程桌面,是通过修改注册表来实现的。当HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Control\Terminal Server中的fDenyTSConnections的值为1时,表示关闭了远程

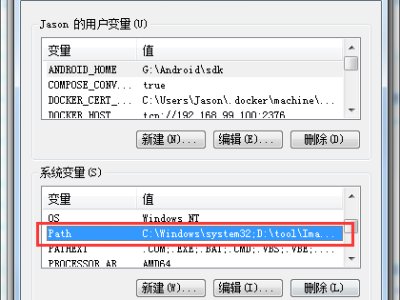

简介ImageMagick是一套功能强大、稳定而且免费的工具集和开发包,可以用来读、写和处理超过185种基本格式的图片文件,包括流行的TIFF、JPEG、GIF、PNG、PDF以及PhotoCD等格式。Ghostscript是一套基于Adobe、PostScript及可移植文档格式(PDF)的页面描述语言等而编译成的免费软件。使用PHP将PDF文档转换为图片需要安装Imagemagick软件、PHP的Imagick扩展、GhostScript软件。安装安装Imagemagick下载地址:http

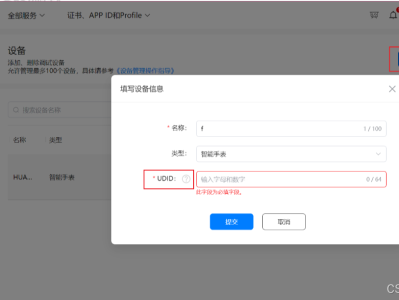

最近在华为手表上安装第三方应用(源码打包构建应用,需要签名)。网上看了教程,在此记录下。准备工作:先安装DevEco Studio开发工具。进入华为 appgallery connect网站(注册、开发者实名认证)https://developer.huawei.com/consumer/cn/service/josp/agc/index.html添加设备,UUID需要用华为 应用调测助手软件获取。获取过程:步骤四:一 私钥、证书DevEco Studio打开项目源码密码随便写(密码包括大小写,